1、2打开要爬取的网页,例如豆瓣 Top250 的 URL 是 ,同时按 option+command+i 或者 Windows 系统的 ctrl+shift+i 进入开发者模式,看到网页 HTML,点击 Web Scraper 图标进入爬虫页面 3创建爬虫点击 create new sitemap 和 create sitemap,随便输入 sitemap name,如;针对淘宝本身的特点,天猫淘宝数据抓取的技术无外乎以下四种技术1通用的网页解析技术,适合解析一些常见的数据,例如关键词排名数据的抓取宝贝标题宝贝下架时间等等2通过浏览器插件技术无论是IE火狐Firefox还是谷歌浏览器Chrome,都有自己的插件技术,淘宝无论如何增强反爬虫技术,终;当使用爬虫抓取网页时,一般只能获取到网页源代码,而无法获取到经过浏览器渲染后的页面内容如果要获取经过浏览器渲染后的内容,需要使用一个浏览器渲染引擎如Selenium来模拟浏览器行为,从而获取到完整的页面内容另外,网站为了防止爬虫抓取数据,可能会采用一些反爬虫技术,如设置验证码限制IP访问;1首先,打开原网页,如下,这里假设要爬取的字段包括昵称内容好笑数和评论数2然后针对以上网页结构,我们就可以直接编写爬虫代码,解析网页并提取出我们需要的数据了,测试代码如下,非常简单,主要用到requests+BeautifulSoup组合,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据动态网;首先,我们需要确定爬虫的目标网站和要收集的数据类型例如,我们可能想要收集一个新闻网站的所有文章标题和链接,或者一个电商网站的所有商品信息根据目标的不同,我们需要编写相应的爬虫逻辑其次,爬虫程序需要从一个或多个起始页面开始,然后按照网站的结构和链接关系遍历整个网站这通常涉及到解析HTML。

2、首先了解下网络爬虫的基本工作流程1先选取一部分精心挑选的种子URL2将这些URL放入待抓取URL队列3从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载下来,存储进已下载网页库中此外,将这些URL放进已抓取URL队列4分析已抓取URL队列中的URL,分析其中的;使用Python爬虫自动化收集CookiesURL等网页数据是提升工作效率的有效途径Python作为编程语言,拥有强大的库支持,非常适合进行网页数据收集工作获取Cookies可以使用Python的request包轻松获取浏览器Cookie信息通过请求网页,可获取诸如过期时间域名路径等详细信息此外,browsercookies包能提供更丰富的;1 视频网站如B站Bilibili这类网站数据结构复杂,不仅包括视频内容,还有弹幕评论等多种互动元素通过爬虫获取弹幕评论等信息,不仅需要理解网页结构,还要应对网站的反爬机制,如本例所示2 社交媒体平台如微博知乎这类网站上的信息丰富多样,包括用户动态文章问答等,需要熟练掌握解。

3、在处理需要滚动下翻的网页时,我们需要对打开网页的步骤进行细致的设置以确保数据的全面提取具体步骤如下首先,打开采集规则编辑界面,可以通过点击打开网页或者点击元素步骤来实现接着,在右侧的高级选项中,勾选“页面加载完向下滚动”,这是为了确保页面完全加载后再进行数据提取然后,根据页面的具体;1抓取网页分析请求 2解析网页寻找数据 3储存数据多页处理 翻页有规律 很多网址在第一页时并没有变化,多翻下一页后规律就出来,比如 豆瓣第一页 和 豆瓣第三页 发现start为40,limit=20,所以猜测start=0就是第一页,每页显示20条数据,对于第三页显示的参数可以一个;八爪鱼采集器是一款功能强大操作简单的网页数据采集工具,可以帮助您快速实现小说网站的数据爬取以下是一个简单的入门教程1 打开八爪鱼采集器,并创建一个新的采集任务2 在任务设置中,输入小说网站的网址作为采集的起始网址3 配置采集规则可以使用智能识别功能,让八爪鱼自动识别小说网站。

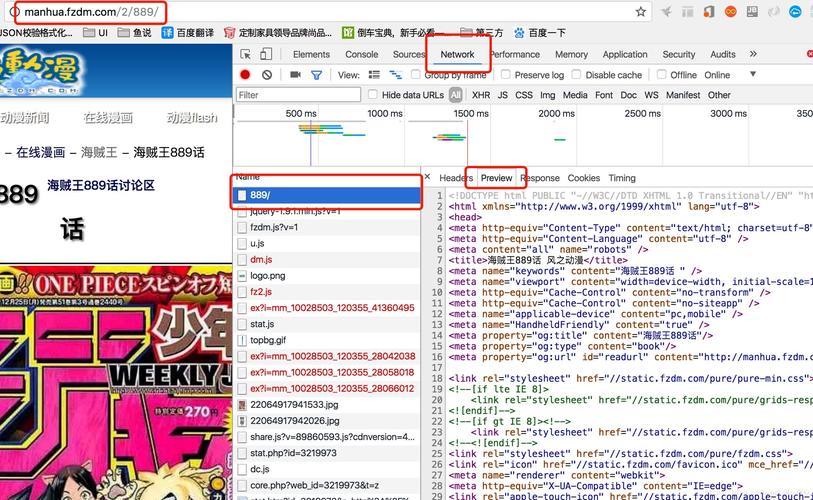

4、爬取的网站是,500彩票网的开奖数据实际存储在页面源代码之外,通过查看开发者工具的network标签可以找到包含所有历史结果的网页在编写爬虫的过程中,博主首先抓取了所有彩票期号及其对应的中奖数字,清晰展示每期的结果针对5+2的号码组合,博主进行了深入分析,特别关注了;具体操作时,首先需要安装pyspider和PhantomJS,然后配置pyspider项目,指定使用PhantomJS作为浏览器在编写爬虫代码时,可以使用pyspider提供的API来模拟点击操作,实现自动加载更多内容例如,可以编写一个任务,模拟点击“加载更多”按钮,然后解析返回的HTML内容,提取所需的数据使用这种方式,不仅可以获取到;以下是使用八爪鱼采集器进行网页数据爬取的步骤1 打开八爪鱼采集器,并创建一个新的采集任务2 在任务设置中,输入要爬取的网址作为采集的起始网址3 配置采集规则可以使用智能识别功能,让八爪鱼自动识别页面的数据结构,或者手动设置采集规则4 如果手动设置采集规则,可以通过鼠标选择页面上;标签里面的hrefs就是每篇文章的URL了把这个URL复制下来,在新的TAB打开,确认确实是文章的地址现在我们通过分析一个网页的结构标签,找到了我们想要的文章URL,我们就可以写爬虫去模拟这个过程了爬虫拿到网页之后,我们可以用正则表达式去查找这个标签,当然,也可以用一些更高级的手段来找不管是。

5、打开要抓取的网页,如豆瓣 Top250,使用快捷键在 Windows 上是 Ctrl+Shift+I,而在 Mac 上是 Option+Command+i进入开发者模式查看网页的 HTML 结构点击 Web Scraper 图标,进入爬虫页面接下来,我们需要根据网页结构创建爬虫首先,创建一个新的 sitemap,并命名。